درخت تصمیم گیری یکی از ابزارهای «داده کاوی» (data mining) است که وقتی با حجم دیتاهای زیادی مواجه باشیم، میتواند به ما کمک کند تا تصمیمهای بهتری بگیریم.

اینطور مواقع معمولاً پارامترهای تاثیرگذار متعددی روی تصمیمات ما اثرگذارند. پس بهترست این پارامترها را ابتدا مشخص کرده و سپس اولویت بندی کنیم. به این ترتیب اولین لایه شکست درخت تصمیمگیری ، براساس مهمترین پارامتر تصمیم ساز خواهد بود و همینطور الی آخر…

درخت تصمیمگیری همچنین یکی از الگوریتمهای «یادگیری ماشین» (machine learning) هم هست. یعنی بوسیله آن به ربات ها یاد داده میشود که در مواجهه با هر پدیده ی محتمل، چه گزینه هایی پیش رو دارند. مثال ساده اش، الگوریتمهای یادگیری که به ربات ها کمک میکنند تا حریف بهتری برای انسانها در بازی شطرنج باشند. با هر حرکت ِ حریف انسانی، ربات حالتهای ممکن را تجزیه و تحلیل میکند تا بهترین و موثرترین انتخاب ِ ممکن را داشته باشد.

پس «درخت تصمیمگیری» یک الگوریتم ِ پیش بینی کننده است. به عبارتی هرکدام از انتخابهای ممکن، در ادامه میتواند به احتمالات بعدی منجر شود. ولی هیچکدام از احتمالات «صفر» نیستند. همه ی احتمالات باید تا جای ممکن در نظر گرفته شوند.

به آنها درختهای تصمیم میگویند زیرا میتوانند یک تصمیمِ خاص (مثلاً اینکه به یک شخص وام بدهیم یا نه) را بر اساسِ اطلاعاتِ گذشته اتخاذ کنند. هدف درخت تصمیم پیش بینی ارزش یک هدف (متغیر خاص) برحسب چندین متغیر وروردی است. پس باید ابتدا «متغیرهای ورودی» را مشخص سازیم.

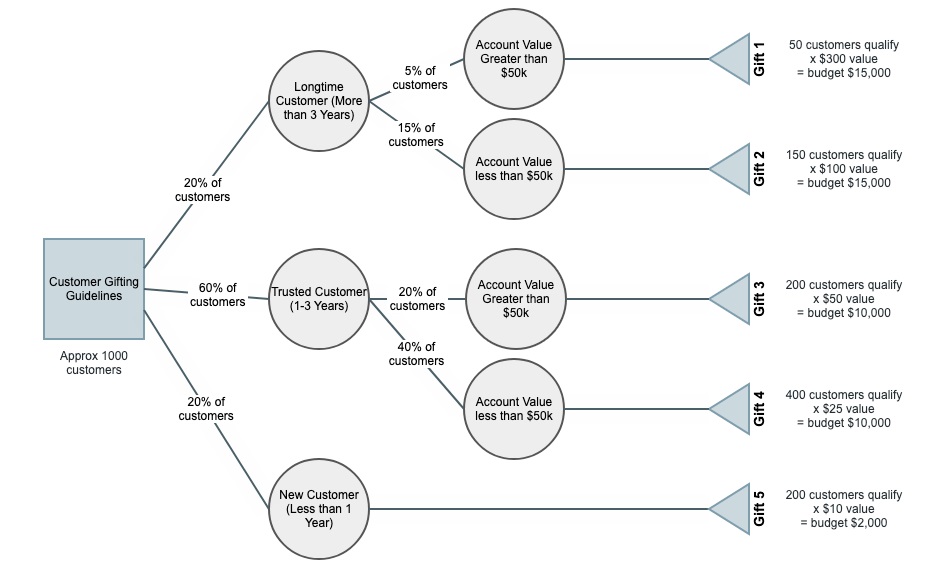

درخت تصمیم دارای سه جزء اصلی است:

- ریشه (Root Nodes): به گره آغازین درخت ریشه گویند.

- برگ (Leaf Nodes): برگ حاوی سوال ها و معیار هایی است که باید به آن ها پاسخ داده شود.

- شاخه (Branches): شاخه ها همانند فلش هایی هستند که گره ها را به یکدیگر متصل می کنند جریان را از سوال تا پاسخ به ما نشان می دهند.

انواع درخت تصمیم

انواع درخت تصمیم

- درخت طبقه بندی (Classification Tree): این نوع درخت زمانی مورد استفاده قرار می گیرد که پیش بینی داده ها در یک سطح صورت بگیرد.

- درخت رگرسیون (Regression Tree): از این درخت هنگامی استفاده می شود که قرار است پیش بینی روی اعداد واقعی صورت بگیرد.

- به دو حالت فوق در اصطلاح CART گویند. (Classification and Regression Tree)

- MARS : به درخت تصمیم گسترش یافته گویند.

مراحل ترسیم درخت تصمیمگیری :

- کار را با موضوع یا تصمیم اصلی آغاز کرده و سوال مربوطه را در یک مربع، در node ریشه ی درخت قرار دهید

- سپس عوامل تاثیر گذار را بر این تصمیم شناسایی کرده و آنها را اولویت بندی نمایید.

- اولین و مهمترین عامل اثرگذار را برای تنظیم لایه اول درخت تصمیمگیری انتخاب کنید.

- نتیجه ی حاصل از انواع احتمالات روی این عامل را در مربع های لایه ی دوم ، بنویسید.

- احتمال وقوع هرکدام از حالتهای لایه اول درخت را روی یالهای منتهی به مربع های حاصل از ردیف 4 بنویسید.

- حالا دومین عامل اثر گذار را از لیست اولویت هایتان انتخاب کنید . … و الی آخر

- وقتی در حال ترسیم لایه ی دوم هستید، بسیار از عوامل براساس انتخاب مرحله ی اول، از مدار خارج میشوند. به این ترتیب اولین «هرس» درختواره انجام میگیرد.

- میتوانید شاخه هایی که احتمال خیلی کمی دارند را نیز از مدار خارج کنید تا ساده تر بتوانید تصمیم بگیرید. این هم نوع دوم از هرس ِ درختواره است.

- در نهایت وزن هرکدام از احتمالات مشخص میشود. یعنی وقتی آخرین لایه درخت را رسم کردید، محتمل ترین نتیجه ها را میتوان پیش بینی کرد.

- با لیست کردن ِ محتمل ترین نتیجه ها ، برای هرکدام یک نقشه ی راه (استراتژی) بنویسید. به این ترتیب برای محتمل ترین اتفاقات، آمادگی لازم را خواهید داشت. یا لااقل ریسک های ممکن را تا حدودی از قبل پیش بینی کرده اید.

مثال : قرض کنید هدف ما بررسی احتمال تمکن کافی برای خرید ویلا (در یک محل مشخص) در پنج سال آینده باشد.

عوامل اثر گذار در این رابطه (به ترتیب اولویت):

- ثابت ماندن قیمت ملک

- درآمد ما برای گذران روزمره و کنار گذاشتنِ پس انداز

- ریسک مخارج قابل پیش بینی ، یا غیرقابل پیش بینی

- احتمال وقوع حوادث طبیعی (مانند سیل و زلزله) در منطقه ای که برای خرید ویلا در نظر گرفته ایم

- و ….

- نکته 1 : در هر دو راهی، انتخابهای ناشی از آن هیچ تداخلی با هم ندارند.

- نکته 2 : شاخه هایی که احتمال بسیار کم داشته باشند، در این درختواره «هَرَس» شده اند.

- نکته 3 : مجموع درصد احتمالات در شاخه های منشعب از یک node برابر با 100% است.

پرسش : درصد ها را بر چه مبنایی در میاوریم؟

پاسخ : بستگی به داده هایی دارند که شما کسب کرده اید. تجربی یا مبتنی بر جمع آوری داده های آماری. به هر حال شما «درصد» برآورد خودتان را روی هر یال (یا شاخه) می نویسید.

نکته : عددی که در نهایت داخل دایره آبی (برگ) نوشته شده، مجموع حاصلضرب اعداد شاخه های منتهی به آنست. بعنوان مثال در باکس صورتی رنگ، مجموع دو عدد 0.35 و 0.1 که حاصلضرب شاخه های منتهی به آن است مساوی با 0.45 شده است.

معایب درخت تصمیمگیری :

عمده اشکال این ابزار، اینست که هرچه متغیرهای اثرگذار بیشتری داشته باشیم، درخت به شکل نمایی بزرگتر میشود و محاسبات پیچیده تری برای اندازه گیری احتمال و اثر هریک از شاخه های آن لازم خواهد بود. به همین دلیل یکی از روشهای حل این مشکل، هرس کردن شاخه های درخت، در احتمالات ِ بسیار کم، و همچنین در نظر گرفتن عوامل تاثیر گذار ِ محدود می باشد. پیشنهاد میشود که در برابر این وسوسه که تمام عوامل تاثیرگذار را لیست کنیم، مقاومت نموده و تنها پارامترهایی که اولویت بالاتری داشته اند را لحاظ کنیم.

همچنین اگر داده هایی که جمع آوری کرده اید، «پیوسته» باشند، «درخت تصمیمگیری» روش مناسبی برای آمایش آنها نیست.

اگر درخت نهایی را درست «هرس» نکنید، تعداد برگهای زیادی وجود خواهد داشت و بدین ترتیب، هزینه ی محاسبات احتمالات افزایش می یابند.

مزایای جانبی :

وقتی به احتمالات فکر میکنیم، در واقع «ریسک» های ممکن را نیز پیش بینی کرده ایم و برای هرکدام از آنها میتوانیم بعداً چاره جویی کنیم. به عبارتی آن دسته از عوامل اثر گذار که مطلوبمان نباشند را شناسایی کرده و با توجه به احتمال وقوعشان، میتوانیم راه حل هایی پیدا کنیم تا اثر آنها را کم کنیم یا به حداقل برسانیم.